Grid Computing

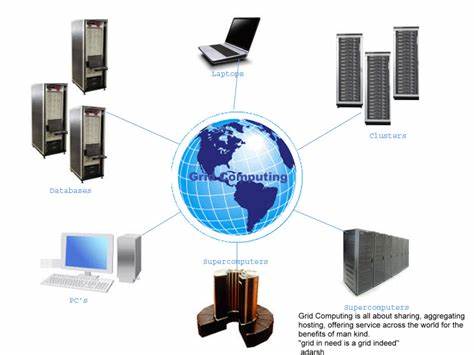

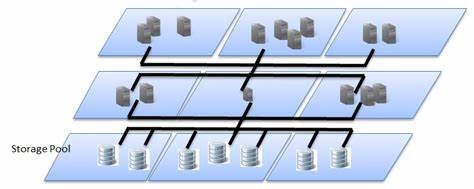

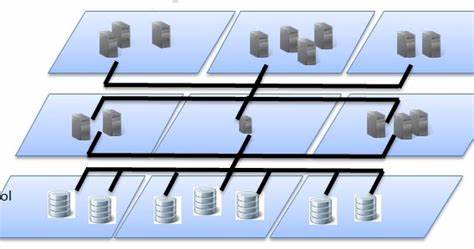

La computación en malla (en inglés grid computing) es una tecnología que permite utilizar de forma coordinada recursos heterogéneos (entre ellos procesadores, almacenamiento y aplicaciones específicas) que no están sujetos a un control centralizado. Es una forma de computación distribuida, en la cual los nodos participantes pueden ser de iguales o distintas arquitecturas y cubrir toda la gama de potencia de cómputo, desde embebidos hasta supercomputadoras.

Los sistemas que forman parte de una topología en malla están interconectados mediante redes de área extensa (por ejemplo internet). Desarrollado en ámbitos científicos a principios de los años 1990, su entrada al mercado comercial siguió la idea de la llamada computación bajo demanda.

El término malla se refiere a una infraestructura que permite la integración y el uso colectivo de ordenadores de alto rendimiento, redes y bases de datos que son propiedad y están administrados por diferentes instituciones. Puesto que la colaboración entre instituciones envuelve un intercambio de datos, o de tiempo de computación, el propósito de la red en malla es facilitar la integración de recursos computacionales. Universidades, laboratorios de investigación o empresas se asocian para formar mallas para lo cual utilizan algún tipo de software que implemente este concepto.

En la computación en malla, las redes pueden ser vistas como una forma de computación distribuida donde un “supercomputador virtual” está compuesto por una serie de computadores agrupados para realizar grandes tareas.

Llamamos malla al sistema de computación distribuido que permite compartir recursos no centrados geográficamente para resolver problemas de gran escala. Los recursos compartidos pueden ser ordenadores (PC, estaciones de trabajo, supercomputadoras, PDA, portátiles, móviles, etc), software, datos e información, instrumentos especiales (radio, telescopios, etc.) o personas/colaboradores.

La computación en malla ofrece muchas ventajas frente a otras tecnologías alternativas. La potencia que ofrecen multitud de computadores conectados en red usando una malla es prácticamente ilimitada, además de que ofrece una perfecta integración de sistemas y dispositivos heterogéneos, por lo que las conexiones entre diferentes máquinas no generarán ningún problema. Se trata de una solución altamente escalable, potente y flexible, ya que evitarán problemas de falta de recursos (cuellos de botella) y nunca queda obsoleta, debido a la posibilidad de modificar el número y características de sus componentes.

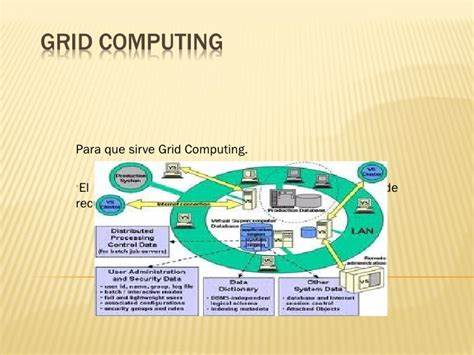

Estos recursos se distribuyen en la red de forma transparente pero guardando unas pautas de seguridad y políticas de gestión de carácter tanto técnico como económico. Así pues, su objetivo será el de compartir una serie de recursos en la red de manera uniforme, segura, transparente, eficiente y fiable, ofreciendo un único punto de acceso a un conjunto de recursos distribuidos geográficamente en diferentes dominios de administración. Esto nos puede llevar a pensar que la computación Grid permite la creación de empresas virtuales. Es importante saber que una malla es un conjunto de máquinas distribuidas que ayudan a mejorar el trabajo sobre software pesados.

El término computación en malla tiene su origen en el comienzo de los años noventa como una metáfora para hacer que el acceso a la potencia de los computadores sea tan sencillo como acceder a una red eléctrica. La metáfora de la red eléctrica para el computación accesible en seguida se volvió canónica cuando Ian Foster y Carl Kesselman publicaron su trabajo seminal, The Grid: Blueprint for a new computer infrastructure en 1999.

Las ideas de la computación mallada (incluidas aquellas de la computación distribuida, programación orientada a objetos y servicios Web) fueron reunidas por Ian Foster, Carl Kesselman, y Steve Tuecke, conocidos como los padres de la computación en malla. Lideraron el esfuerzo por la creación del Globus Toolkit incorporando no solo la gestión de la computación, sino también la gestión del almacenamiento, aprovisionamiento de seguridad, traslado de datos, monitorización, y un conjunto de herramientas para el desarrollo de servicios adicionales basados en la misma infraestructura, incluyendo la negociación de los acuerdos, mecanismos de notificación, servicios de activación y agregación de información. Mientras que Globus Toolkit se mantiene como el estándar de facto para soluciones de creación de redes, otras herramientas han sido creadas para responder a una serie de servicios necesarios para crear una red empresarial o global.

En 2007, el término computación en la nube se hizo popular, lo cual es conceptualmente similar a la definición canónica de Foster de la computación en malla (en términos de recursos de computación consumidos tal como la electricidad en una red eléctrica).

Existen muchos proyectos que han sido desarrollados en esta línea, tales como Edonkey, Emule o Limewire. Se trata de programas para compartir datos a nivel mundial entre diferentes máquinas. Las redes en malla y P2P tienen mucho en común y especialmente la idea básica de compartición de recursos. Entre las características diferentes podemos ver la P2P como más anónima y generalizada en ordenadores de usuarios de Internet, mientras que las mallas nacen de una estructura de nodos más controlada y jerarquizada en centros científicos. Una primera experiencia fue GriPhyN, para unir nodos en el proceso de físicas de altas energías en Estados Unidos.

Otro proyecto también muy importante es SETI@home. Éste cuenta con miles de PC repartidos por Internet que ceden tiempo de sus procesadores, ciclos de proceso desocupados, para analizar señales buscando patrones inteligentes extraterrestres. Sin embargo, su uso destaca también en los centros de investigación desde finales del 1990 en proyectos que van desde Física de Partículas a Astrofísica o incluso Biología. En Europa con el apoyo de proyectos de Centro Europeo Investigación Nuclear y el programa marco europeo se creó el software y red EDG (malla de datos europea). El uso de la computación mallada en estos campos ha supuesto una mejora exponencial en los últimos años.

Las empresas e instituciones que han participado en el desarrollo de estas tecnologías quieren entrar cuanto antes en una etapa de explotación comercial. Empresas como Microsoft y Sun Microsystems se han dado cuenta de la importancia que tendrá a medio plazo ofrecer computación en malla a sus clientes. Destacamos el papel de IBM invirtiendo en mallas como plataforma para ofrecer a sus clientes las ventajas como ahorro de tiempo y recursos económicos.

Existen varias soluciones comerciales en forma de empresas, por ejemplo:

Existen diversos middleware con capacidades y funcionalidades muy variadas que, en función de la complejidad, servicios ofrecidos y dimensión de la red en malla a implantar, se seleccionará la opción idónea. Las soluciones middleware, todas ellas de código abierto, utilizadas (por ejemplo por Andago) son: EGEE para grandes proyectos, Globus Solutions para proyectos medios, Grid Engine para pequeñas implantaciones.

Para la segmentación del mercado de la computación en malla, hemos de considerar dos perspectivas: la parte del proveedor y la parte del usuario.

La totalidad del mercado de computación en malla abarca múltiples mercados específicos. Estos son el mercado del middleware, el mercado de aplicaciones habilitadoras, el mercado de computación bajo demanda y el mercado del software como servicio (SaaS). El middleware para mallas es un producto software específico, el cual permite la compartición de recursos heterogéneos y organizaciones virtuales. Se instala e integran en la infraestructura existente de la compañía o las compañías involucradas, y provee de una capa especial situada sobre la infraestructura heterogénea y las aplicaciones específicas de usuario. Los principales middleware son Globus Toolkit, gLite y UNICORE.

La computación bajo demanda se refiere al aprovisionamiento de computación en malla y aplicaciones como servicio tanto como una utilidad de malla abierta o una solución de hospedaje para una organización u organización virtual (VO). Los principales competidores en el marcado de computación bajo demanda son Sun Microsystems, IBM y HP.

Las aplicaciones habilitadoras de mallas son programas específicos que pueden utilizar la infraestructura en malla. Esto es posible mediante el uso del middleware para mallas.

El software como servicio (SaaS) es un «software que se posee, provee y se gestiona remotamente por uno o más proveedores».[cita requerida] Adicionalmente, las aplicaciones SaaS se basan en un solo set de código común y definiciones de datos. Son consumidos en un modelo uno a muchos, y utiliza un modelo de suscripción para pago en función del uso. Los proveedores de SaaS no son necesariamente dueños de los suministros de computación, los cuales son requeridos para ejecutar su SaaS. El mercado de la computación bajo demanda provee de suministros de computación para los proveedores de SaaS.

Para compañías que lo demandan o usuarios del mercado de la computación en malla, los diferentes segmentos tienen implicaciones significativas para su estrategia de despliegue de TI. La estrategia de despliegue de TI así como el tipo de inversiones de TI hechas son aspectos relevantes para usuarios de mallas potenciales y juegan un papel importante en la adopción de esta tecnología.

Se relaciona el concepto de malla con la nueva generación del protocolo de internet. El nuevo protocolo de Internet IPv6 permitirá trabajar con una Internet más rápida y accesible. Una de las ideas clave en la superación de las limitaciones actuales de Internet IPv4 es la aparición de nuevos niveles de servicio que harán uso de la nueva capacidad de la red para intercomunicar los ordenadores.

Este avance en la comunicación permitirá el avance de las ideas de computación en malla al utilizar como soporte la altísima conectividad de Internet. Es por ello que uno de los campos de mayor innovación en el uso de la computación en malla, fuera de los conceptos de supercomputación, es el desarrollo de un estándar para definir los servicios en malla frente a los servicios web.

No obstante, la computación en malla presenta algunos inconvenientes que deben solucionarse. Estos problemas son:

La computación en malla supone un avance respecto a la World Wide Web. Esta proporciona un acceso transparente a información que está almacenada en millones de ordenadores repartidos por todo el mundo. Frente a ello, la red en malla es una infraestructura nueva que proporciona acceso transparente a potencia de cálculo y capacidad de almacenamiento distribuida por una organización o por todo el mundo.

Los requisitos que debe cumplir cualquier red en malla son:

Los datos deben compartirse entre miles de usuarios con intereses distintos. Se deben enlazar los centros principales de supercomputación, no solo los PC. Se debe asegurar que los datos sean accesibles en cualquier lugar y en cualquier momento. Debe armonizar las distintas políticas de gestión de muchos centros diferentes. Debe proporcionar seguridad.

Y los beneficios que se obtienen:

Estos beneficios tendrán repercusión en muchos campos:

La tecnología derivada de la malla abre un enorme abanico de posibilidades para el desarrollo de aplicaciones en muchos sectores. Por ejemplo: desarrollo científico y tecnológico, educación, sanidad, y administración pública.

La computación en malla, en general, es un tipo especial de computación paralela que se basa en computadores completos (con CPU, almacenamiento, fuentes de alimentación, interfaces de red, etc.) conectados a una red (privada, pública o internet) por una interfaz de red convencional aportando un hardware sencillo, en comparación al diseño y construcción de baja eficiencia de un pequeño número de supercomputadores personalizados. La principal desventaja en cuanto a rendimiento es que los diversos procesadores y áreas locales de almacenamiento no tienen conexiones de alta velocidad. Esta composición es apropiada para aplicaciones donde pueden tener lugar múltiples computaciones paralelas independientemente, sin la necesidad de comunicar resultados inmediatos entre procesadores.

Existen también algunas diferencias en la programación y el despliegue. La escritura de programas que se ejecuten en el entorno de un supercomputador puede resultar costosa y compleja, la cual puede tener un sistema operativo personalizado, o requerir de un programa para lidiar con los problemas de concurrencia. Si se puede paralelizar un problema adecuadamente, una capa “delgada” de infraestructura mallada puede permitir que programas convencionales e independientes se ejecuten en múltiples máquinas. Esto hace posible escribir y depurar sobre una sola máquina convencional, y elimina complicaciones debidas a múltiples instancias de un mismo programa ejecutándose en la misma memoria compartida y espacio de almacenamiento simultáneamente.

En definitiva, nos encontramos ante un paradigma de computación distribuida altamente versátil, escalable y que permite combinar la potencia de muchos equipos para lograr una capacidad global prácticamente ilimitada. Sus principales inconvenientes provienen de la dificultad para sincronizar los procesos de todos estos equipos, monitorizando recursos, asignando cargas de trabajo y estableciendo políticas de seguridad informática fiables.

Se trata de un paradigma computacional en fase de desarrollo actualmente que ya ofrece servicios a muchos campos de investigación y que en el futuro tendrá una mayor influencia si cabe en dichos campos, al gozar de una estructura evolucionada respecto a la actual, con mayor robustez, mucho más rápida en cuanto a la comunicación entre sus equipos y, obviamente, con una mayor capacidad computacional de cada máquina debido a la evolución en términos de procesamiento y de rendimiento del hardware.

Escribe un comentario o lo que quieras sobre Grid Computing (directo, no tienes que registrarte)

Comentarios

(de más nuevos a más antiguos)

Aún no hay comentarios, ¡deja el primero!