Covarianza

En probabilidad y estadística, la covarianza es un valor que indica el grado de variación conjunta de dos variables aleatorias respecto a sus medias. Es el dato básico para determinar si existe una dependencia entre ambas variables y además es el dato necesario para estimar otros parámetros básicos, como el coeficiente de correlación lineal o la recta de regresión.

Cuando los valores altos de una de las variables suelen mayoritariamente corresponderse con los valores altos de la otra, y lo mismo se verifica para los pequeños valores de una con los de la otra, se corrobora que tienden a mostrar comportamiento similar lo que se refleja en un valor positivo de la covarianza

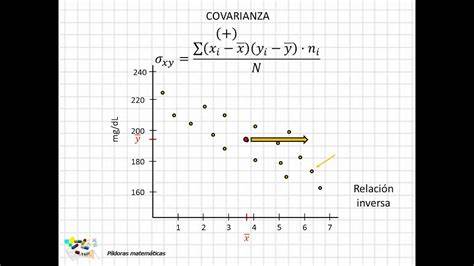

Por el contrario, cuando los valores altos de una variable suelen corresponder mayoritariamente a los menores valores de la otra, expresando un comportamiento opuesto, la covarianza es negativa.

El signo de la covarianza, por lo tanto, expresa la tendencia en la relación lineal entre las variables.

La magnitud requiere un esfuerzo adicional de interpretación:

La versión normalizada de la covarianza, el coeficiente de correlación indica la magnitud de la especificidad de la relación lineal.

Se debe distinguir entre:

(1) la covarianza de dos variables aleatorias, parámetro estadístico de una población considerado una propiedad de la distribución conjunta y

(2) la covarianza muestral que se emplea como un valor estadísticamente estimado es una de las principales causas o motivos de la covarianza.

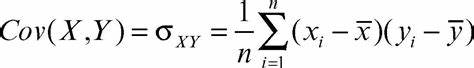

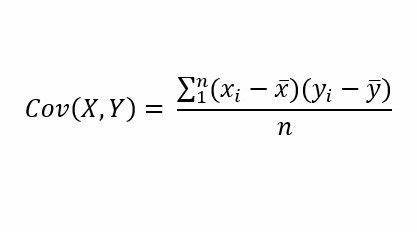

La covarianza entre dos variables aleatorias y se define como

siempre que , y , donde , y denota los valores esperados de las variables aleatorias , y respectivamente. Como la esperanza es un operador lineal entonces la expresión anterior se puede escribir de otra forma

Si las variables aleatorias y pueden tomar los valores y para con probabilidad y respectivamente entonces la covarianza puede ser expresada en términos de y como

o expresadas como

Si es un vector aleatorio de dimensión , es decir, donde para son variables aleatorias, la matriz de covarianza, denotada por , está dada por

es decir, la -ésima entrada de corresponde a la covarianza entre y que puede ser representada como

en particular, cuando , entonces

por lo que la matriz puede ser escrita como

La varianza es un caso particular de la covarianza cuando dos variables aleatorias son idénticas

Sean , , y variables aleatorias y entonces

Estas propiedades se deducen de manera casi directa de la definición de la covarianza.

Para una secuencia de variables aleatorias y para valores se tiene

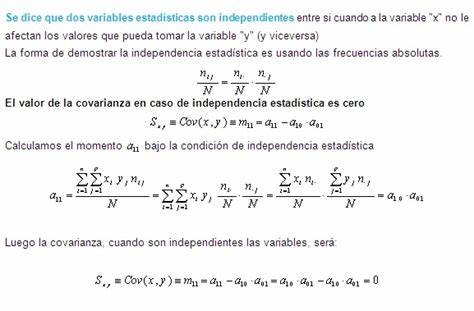

A las variables aleatorias cuya covarianza es cero se dicen que son no correlacionadas.

Si e son variables aleatorias independientes entonces su covarianza es cero, esto es

esto ocurre por la propiedad de independencia

entonces reemplazando en la fórmula de la covarianza se obtiene

Lo opuesto, sin embargo, generalmente no es cierto: algunos pares de variables aleatorias tienen covarianza cero pese a que no son independientes. Bajo algunas hipótesis adicionales, la covarianza de valor cero implica independencia, como por ejemplo en el caso de la distribución normal multivariante.

La mayoría de las propiedades de la covarianza se deducen de las del producto escalar:

De hecho, la covarianza es un producto interior sobre el espacio cociente de las variables aleatorias de momentos finitos iguales salvo constante.

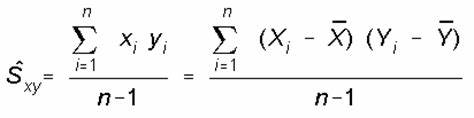

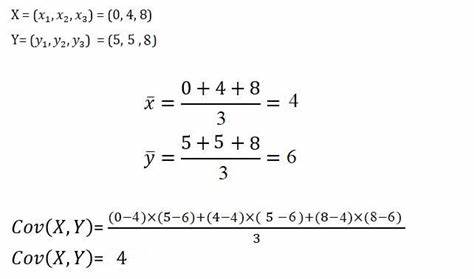

Si y son variables aleatorias que toman los valores y para entonces se puede estimar la covarianza entre y , este estimador denotado por se define como

donde

denotan la media muestral.

El estimador tiene la propiedad de que es un estimador insesgado.

Escribe un comentario o lo que quieras sobre Covarianza (directo, no tienes que registrarte)

Comentarios

(de más nuevos a más antiguos)

Aún no hay comentarios, ¡deja el primero!

![{displaystyle operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{displaystyle operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5)

![{displaystyle operatorname {E} [XY]<infty }](https://wikimedia.org/api/rest_v1/media/math/render/svg/ffd9aec97d688967b53e343d46d69c86b79b7ba6)

![{displaystyle operatorname {E} [XY]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/612af0bbf256874e0b0551305574be507f9ff805)

![{displaystyle operatorname {P} [X=x_{i}]=1/n}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8557c591f9ad0ce0cd89b4ec756757eeae3cd940)

![{displaystyle operatorname {P} [Y=y_{i}]=1/n}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e17399d6c487c7ac27cb98b313e57d1a6834e659)